引言

引言

Apache Spark 是一个综合性且高效的分布式计算引擎,兼具批处理和流计算能力,利用内存进行并行计算。官方数据表明,Spark的内存计算速度比MapReduce快100倍。作为当前最流行的计算框架,Spark已展现出其卓越的性能。

Apache Flink 是一个分布式大数据处理引擎,提供基于数据流的状态计算,被誉为下一代大数据处理引擎,发展迅速并在行业内积累了众多最佳实践。

这两种框架都非常出色,但它们之间有何不同?在还没有完全掌握Spark的情况下,程序员们又要面对Flink的挑战。本文将从部分功能上探讨这两款大数据处理引擎。

编程模型

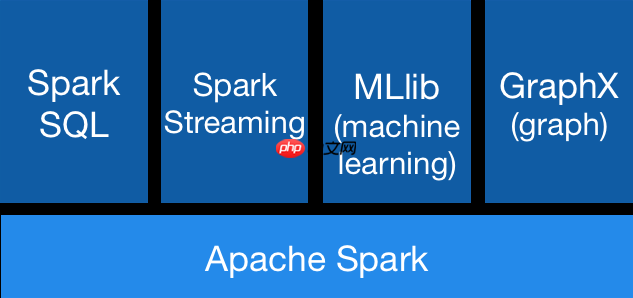

Spark可以被视为一站式的分布式计算引擎,支持批处理、流计算、机器学习和图计算。

Spark Core:Spark的核心模型,其底层的高级抽象RDD(弹性分布式数据集)具有高容错性,是并行计算的基础。Spark SQL:Spark提供了Spark SQL模块来处理结构化数据,支持交互式SQL、DataFrame API以及多种语言。Spark Streaming:一个可扩展且容错的流计算框架,基于微批处理模式,Spark 2.0引入的Structured Streaming进一步定义了流计算的多方面语义。MLlib:Spark原生支持的机器学习库,包含主流的统计和机器学习算法。GraphX:Spark提供的分布式图计算框架,适用于处理复杂的业务场景,如社交关系、金融担保等。Flink与Spark类似,同样提供了多种编程模型,从流计算到批处理,再到结构化数据处理以及机器学习、图计算等。

Spark Core:Spark的核心模型,其底层的高级抽象RDD(弹性分布式数据集)具有高容错性,是并行计算的基础。Spark SQL:Spark提供了Spark SQL模块来处理结构化数据,支持交互式SQL、DataFrame API以及多种语言。Spark Streaming:一个可扩展且容错的流计算框架,基于微批处理模式,Spark 2.0引入的Structured Streaming进一步定义了流计算的多方面语义。MLlib:Spark原生支持的机器学习库,包含主流的统计和机器学习算法。GraphX:Spark提供的分布式图计算框架,适用于处理复杂的业务场景,如社交关系、金融担保等。Flink与Spark类似,同样提供了多种编程模型,从流计算到批处理,再到结构化数据处理以及机器学习、图计算等。

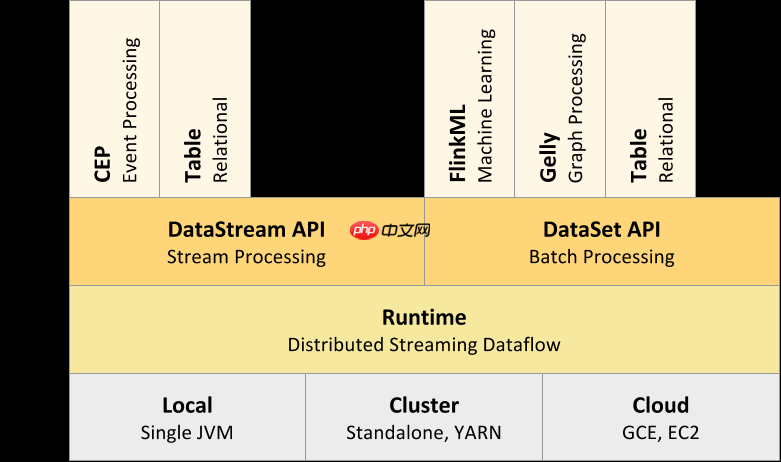

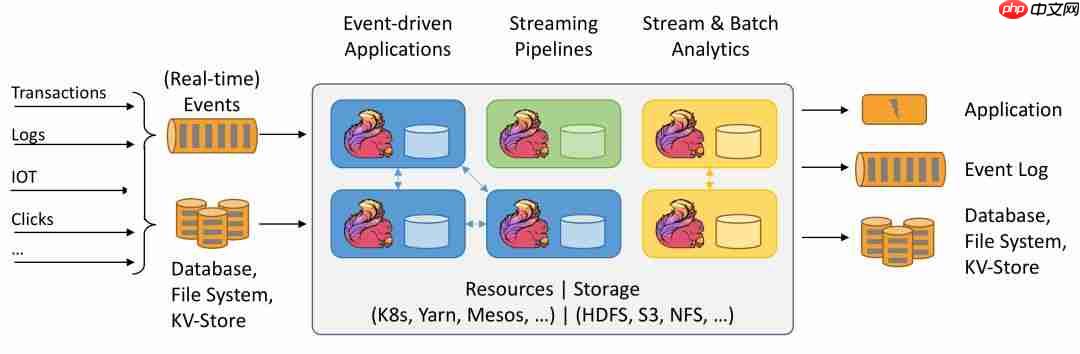

DataStream API / DataSet API:这是Flink的核心编程模型,这两套API分别针对流处理和批处理,是基于有状态流处理和Runtime的高级抽象,适用于大部分业务逻辑处理。Table API & SQL:基于DataStream API和DataSet API,面向结构化数据处理的高级抽象,提供类似关系型数据库的Table和SQL查询功能,简化数据流操作。CEP:DataStream API / DataSet API的另一个高级抽象,用于复杂事件处理。FlinkML:Flink的机器学习库,是批处理API的高级封装,提供可扩展的机器学习算法、直观的API和工具。Gelly:Flink的图计算库,基于批处理API的封装,提供了创建、转换和修改图的方法以及图算法库。流处理方面对比

DataStream API / DataSet API:这是Flink的核心编程模型,这两套API分别针对流处理和批处理,是基于有状态流处理和Runtime的高级抽象,适用于大部分业务逻辑处理。Table API & SQL:基于DataStream API和DataSet API,面向结构化数据处理的高级抽象,提供类似关系型数据库的Table和SQL查询功能,简化数据流操作。CEP:DataStream API / DataSet API的另一个高级抽象,用于复杂事件处理。FlinkML:Flink的机器学习库,是批处理API的高级封装,提供可扩展的机器学习算法、直观的API和工具。Gelly:Flink的图计算库,基于批处理API的封装,提供了创建、转换和修改图的方法以及图算法库。流处理方面对比

Flink主要作为流处理引擎,而Spark在流处理方面支持Spark Streaming和Structured Streaming(2.x)。以下将从流处理机制、状态管理、时间语义、Exactly-Once语义等方面阐述两者的差异。

流处理机制

Spark Streaming的流处理机制是将不断流入的数据按一定时间间隔分割成小批次,然后通过Spark引擎处理并输出到外部系统。这实际上是微批处理,因此上述时间间隔称为Batch Duration,即批处理时间间隔。Spark Streaming这种将流视为批的设计思想具有高吞吐量,但无法避免较高的延迟,因此在实时性要求极高的场景中不适用。

Flink本质上是一个流处理引擎,基于消息事件驱动,并引入了状态管理,因此能够对数据流进行有状态计算。Flink的设计理念是将批视为一种有限的流,这样在流处理过程中也能发挥批处理的特性,实现了批流一体化。

Flink本质上是一个流处理引擎,基于消息事件驱动,并引入了状态管理,因此能够对数据流进行有状态计算。Flink的设计理念是将批视为一种有限的流,这样在流处理过程中也能发挥批处理的特性,实现了批流一体化。

状态管理

状态管理

Spark Streaming支持两种状态管理操作:updateStateByKey和mapWithState,分别用于满足类似全量和增量的操作。而在Structured Streaming中,支持用户自定义的mapGroupsWithState和flatMapGroupsWithState状态操作。

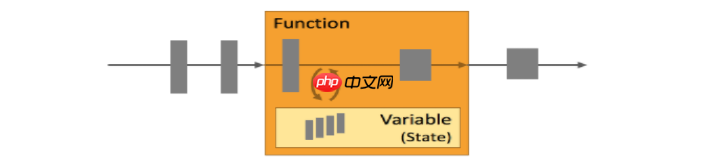

Flink从设计之初就引入了状态管理,其最突出的表现是能够进行有状态处理(Stateful Processing),示意图如下:

时间语义

时间语义

Spark Streaming仅支持处理时间,而在Structured Streaming模型中同时支持处理时间和事件时间。

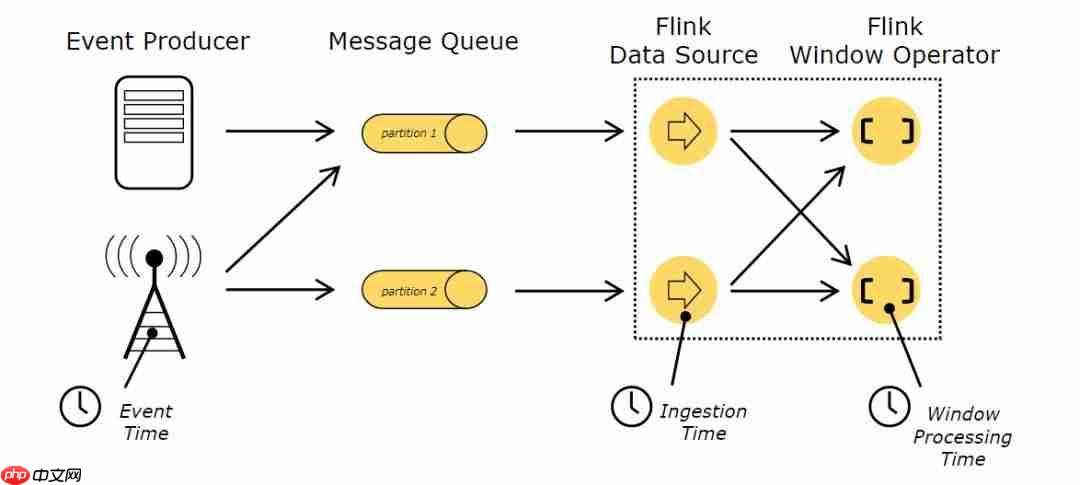

在Flink中,时间和状态是流应用中的两大元素,Flink支持三种时间语义,含义与示图如下:

事件时间(Event Time):是数据产生或消息创建的时间;接入时间(Ingestion Time):是数据或消息进入Flink计算引擎的时间;处理时间(Processing Time):是数据被Flink计算引擎处理的时间。 Exactly-Once语义

Exactly-Once语义

在容错性方面,Spark Streaming只能保证At-most-Once或At-least-Once这种至多或至少一次的处理语义,无法保证Exactly-Once这种严格一次的处理语义。通常只实现At-least-Once的处理,确保数据不丢失,但不能保证数据不会被重复处理,因此要求输出端支持幂等操作或更新操作。

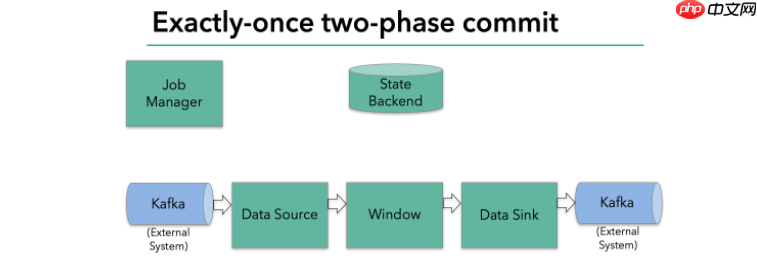

Flink能够保证Exactly-Once状态一致性的语义,整体上是通过checkpoint机制和两阶段提交协议(two-phase commit)实现的。

具体实现思路可以参考 https://www.php.cn/link/4a487a7a8a7320a4e05a9b3ee8b1d9ec

具体实现思路可以参考 https://www.php.cn/link/4a487a7a8a7320a4e05a9b3ee8b1d9ec

总结

总的来说,Spark是一个通用且快速的大数据处理引擎,集成了批处理、流处理、机器学习和图计算,基于内存的迭代计算更加高效,目前也在不断增强包括流处理在内的能力。Flink则更多地作为流计算引擎,但不仅仅限于流计算,实际上具有与Spark相似的计算模型,特别是在流计算的诸多方面优于Spark。

欢迎在留言区发表自己的看法~

如果喜欢本文,请点个赞吧

路由网

路由网